python生成词云

准备

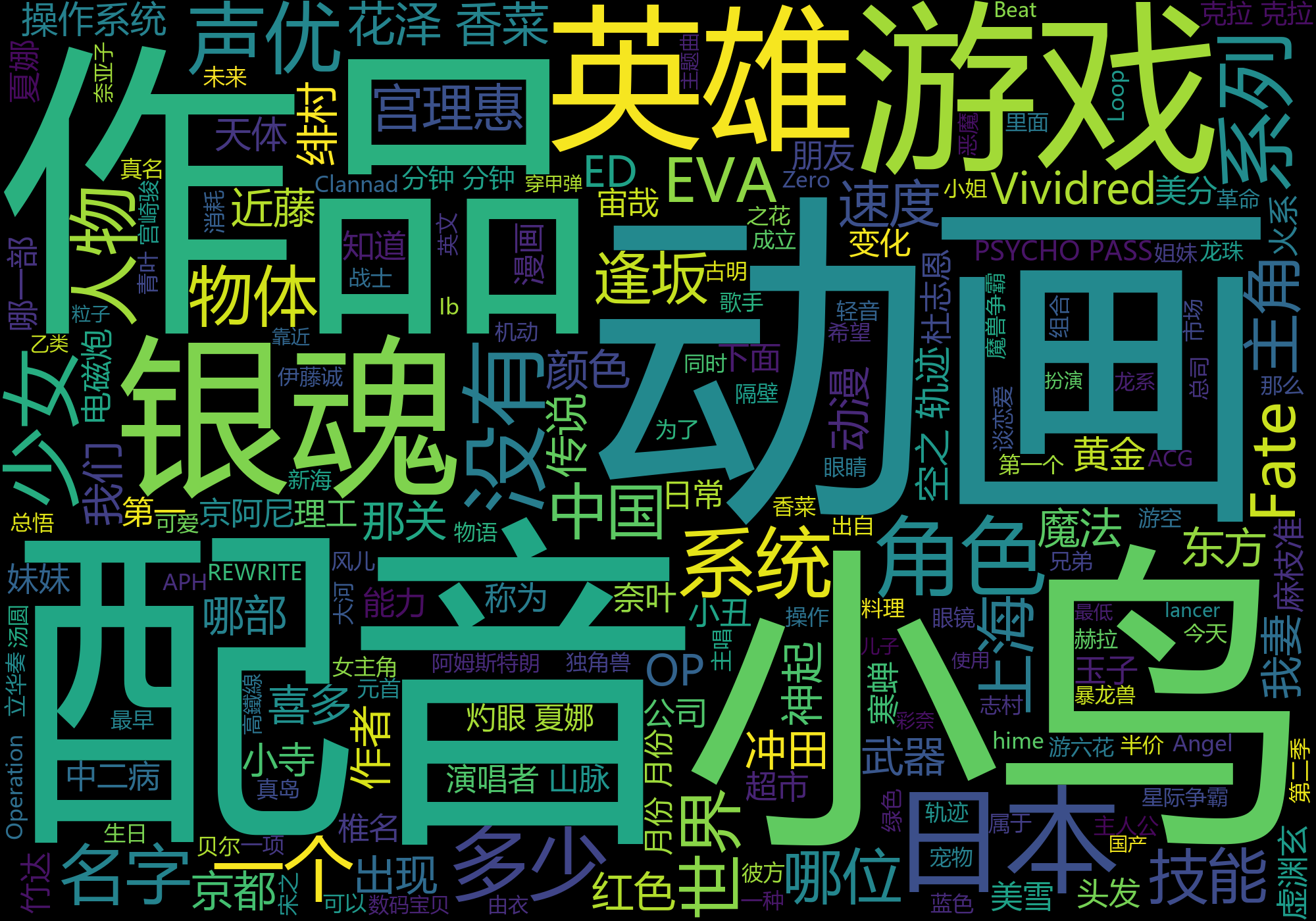

我们现在开始制作一个词云程序。

新建一个python文件。

安装所需的第三方库,它们是jieba和wordcloud。安装完后开始编写程序。

jieba是优秀的中文分词第三方库,使用pip安装后可以使用其来对中文文本进行分词。

wordcloud是一款知名度很高的词云生成工具。

编写

首先调用jieba和wordcloud模块。

import jieba

import wordcloud

接着,我们把程序目录下的txt文档命名为“B站测试题.txt”,在程序中输入以下代码读取该文档。

f=open("B站测试题.txt","r",encoding="gbk")

在上面这段代码中,我们读取了“B站测试题”这一文档,并存储在变量f中。

现在我们要读取文字,把它储存在新的变量t中,在程序中加入如下代码:

t=f.read()

读取完毕后,我们要关闭文档。

f.close()

下面我们把文章中的词组提取出来,并用空格分开。

ls=jieba.lcut(t)

txt=" ".join(ls)

下面我们新建一个词云对象。

w=wordcloud.WordCloud(width=2000,height=1400,font_path="msyh.ttc")

在上面这段代码中,我们新建了一个词云对象,并将其命名为w,词云图片高度为1400像素,宽度2000像素,字体为微软雅黑。

现在我们将之前生成的词组导入词云中。

w.generate(txt)

w.to_file("pic.png")

编写完的代码如下:

import jieba

import wordcloud

f=open("B站测试题.txt","r",encoding="gbk")

t=f.read()

f.close()

ls=jieba.lcut(t)

txt=" ".join(ls)

w=wordcloud.WordCloud(width=2000,height=1400,font_path="msyh.ttc")

w.generate(txt)

w.to_file("pic.png")

运行后,程序目录下会产生名为pic.png的文件。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 JackZhang's Blog!